打造你的电子老婆!绿联私有云部署数字人项目,赛博女友在线撒娇

打造你的电子老婆!绿联私有云部署数字人项目,赛博女友在线撒娇

亲爱的粉丝朋友们好啊!今天熊猫又来介绍好玩有趣的Docker项目了,喜欢的记得点个关注哦!

引言

AI一直是近两年最热门的话题,而随着AI技术的发展“电子老婆”也越来越成熟了,将AI驱动放进皮套之中,随后再通过自定义角色人设、记忆、表情以及表情或动作捕捉,一个有“灵魂”的数字人就诞生了,你可以像朋友一样和她相识,将她作为你的恋爱导师、心灵导师亦或者生活伴侣。今天要介绍的便是项目VirtualWife,一个虚拟数字人项目。(github地址:https://github.com/yakami129/VirtualWife)

项目预览

项目预览项目具备以下特性:

- 支持一键通过Docker快速部署

- 支持在Linux/Windows/MacOS系统进行部署

- 支持自定义角色设定

- 支持更换角色模型,可从VRM模型市场Vroid下载

- 支持长短期记忆功能

- 支持多LLM模型切换,并且支持私有化模型(ollama)

- 支持文字驱动表情,文字驱动动作

- 支持B站进行直播

- 支持通过中文进行语音对话

- 支持Edge(微软)、Bert-VITS2语音切换

流式传输数据,拥有更快的响应速度

项目部署

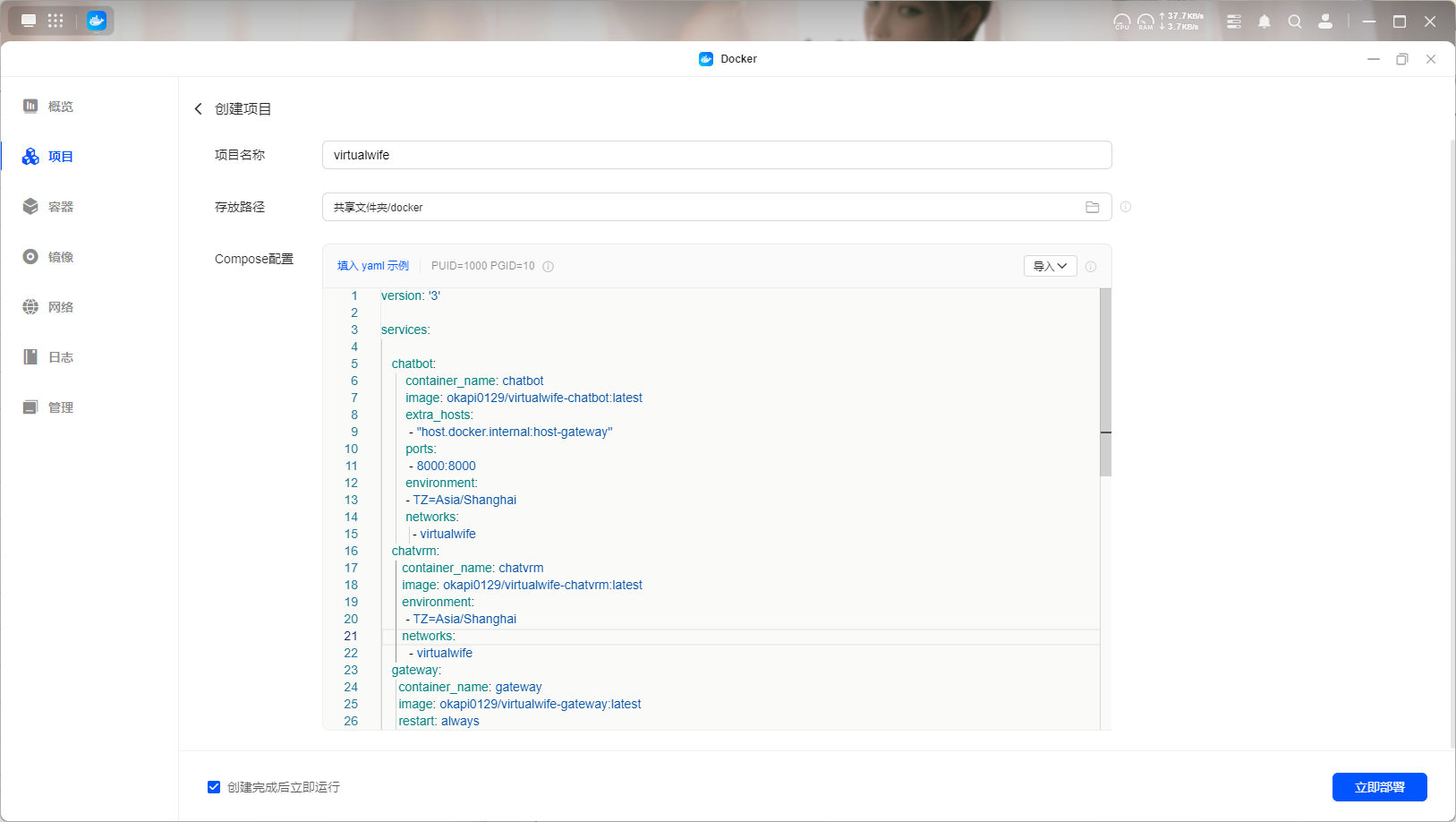

前两天有粉丝让我多写点绿联私有云的教程文,所以今天咱们就用绿联来写写VirtualWife的部署,加上项目本身由多个容器项目驱动,而绿联的UGOSPro的Docker是支持Docker-Compose的,且体验起来十分好用,所以部署起来也是非常方便。

绿联容器

绿联容器该项目的部署需要用到三个容器项目,而作者也是给到了docker-compose文件,所以我们只需要根据自身NAS情况小小修改一下复制到绿联Docker的项目中新建就可以了,这里给到compose配置代码。

version: '3'

services:

chatbot:

container_name: chatbot

image: okapi0129/virtualwife-chatbot:latest

extra_hosts:

- "host.docker.internal:host-gateway"

ports:

- 8000:8000

environment:

- TZ=Asia/Shanghai

networks:

- virtualwife

chatvrm:

container_name: chatvrm

image: okapi0129/virtualwife-chatvrm:latest

environment:

- TZ=Asia/Shanghai

networks:

- virtualwife

gateway:

container_name: gateway

image: okapi0129/virtualwife-gateway:latest

restart: always

ports:

- 8080:80

environment:

- TZ=Asia/Shanghai

networks:

- virtualwife

networks:

virtualwife:

driver: bridge代码中的端口根据自身情况填写,确定填写无误之后直接点击立即部署就可以了。

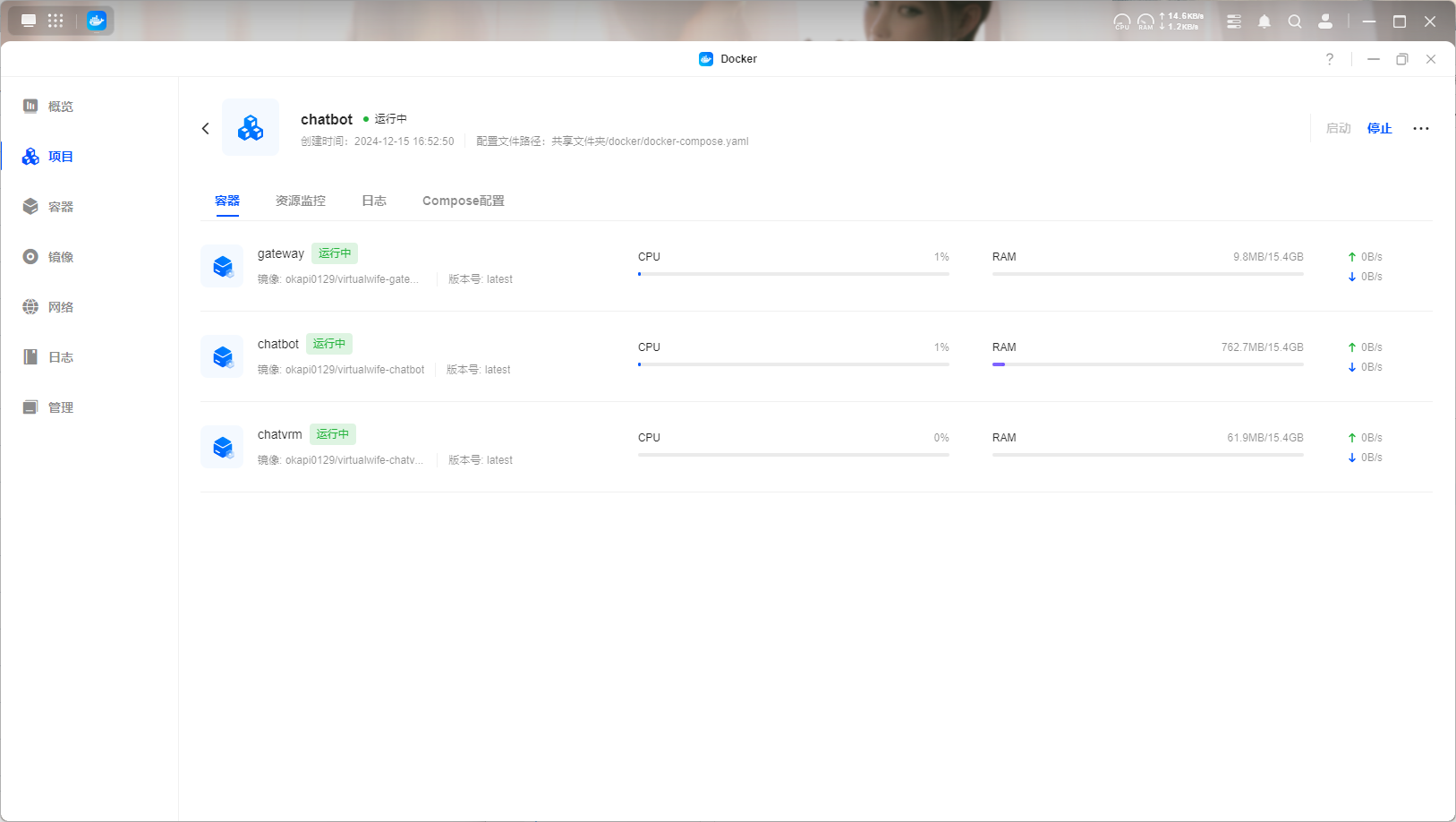

项目部署

项目部署整个项目会有三个容器构成,在项目里点击控制台就能看到各个容器的运行状况。

项目容器

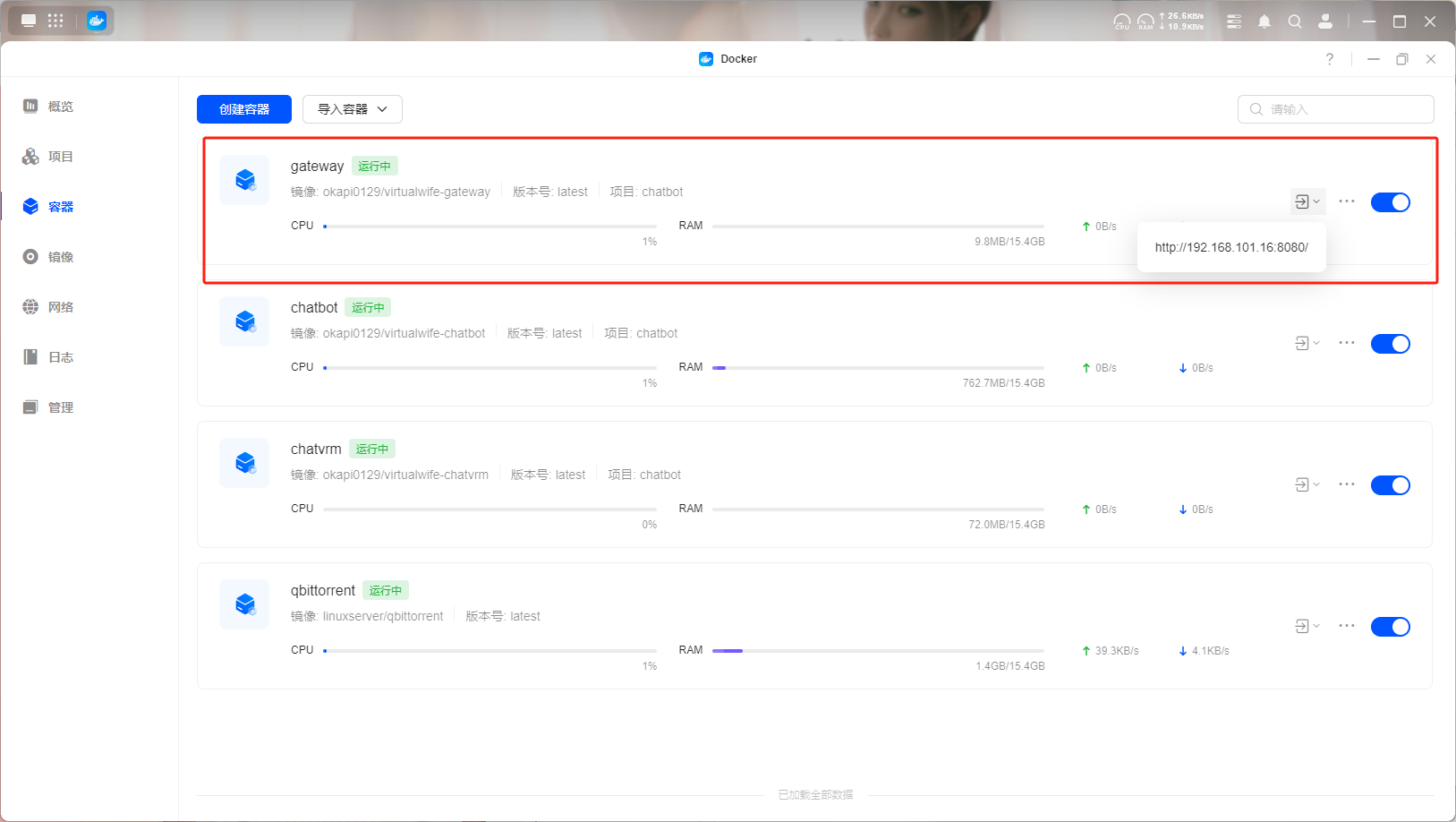

项目容器项目的WEB界面为gateway项目,熊猫这里端口映射为了8080,所以咱们的web界面也就是http://绿联云IP:8080端口号,或者直接在容器界面找到该项目,点击快捷访问也能直接访问web界面。

容器界面

容器界面项目使用

打开项目界面,模型的加载需要等待几秒钟,整体界面左上方有设置和会话记录,下方能进行语音输入以及文字输入,同时鼠标滑动滚轮可以设置模型的大小,右键按住可拖动模型位置。

主界面

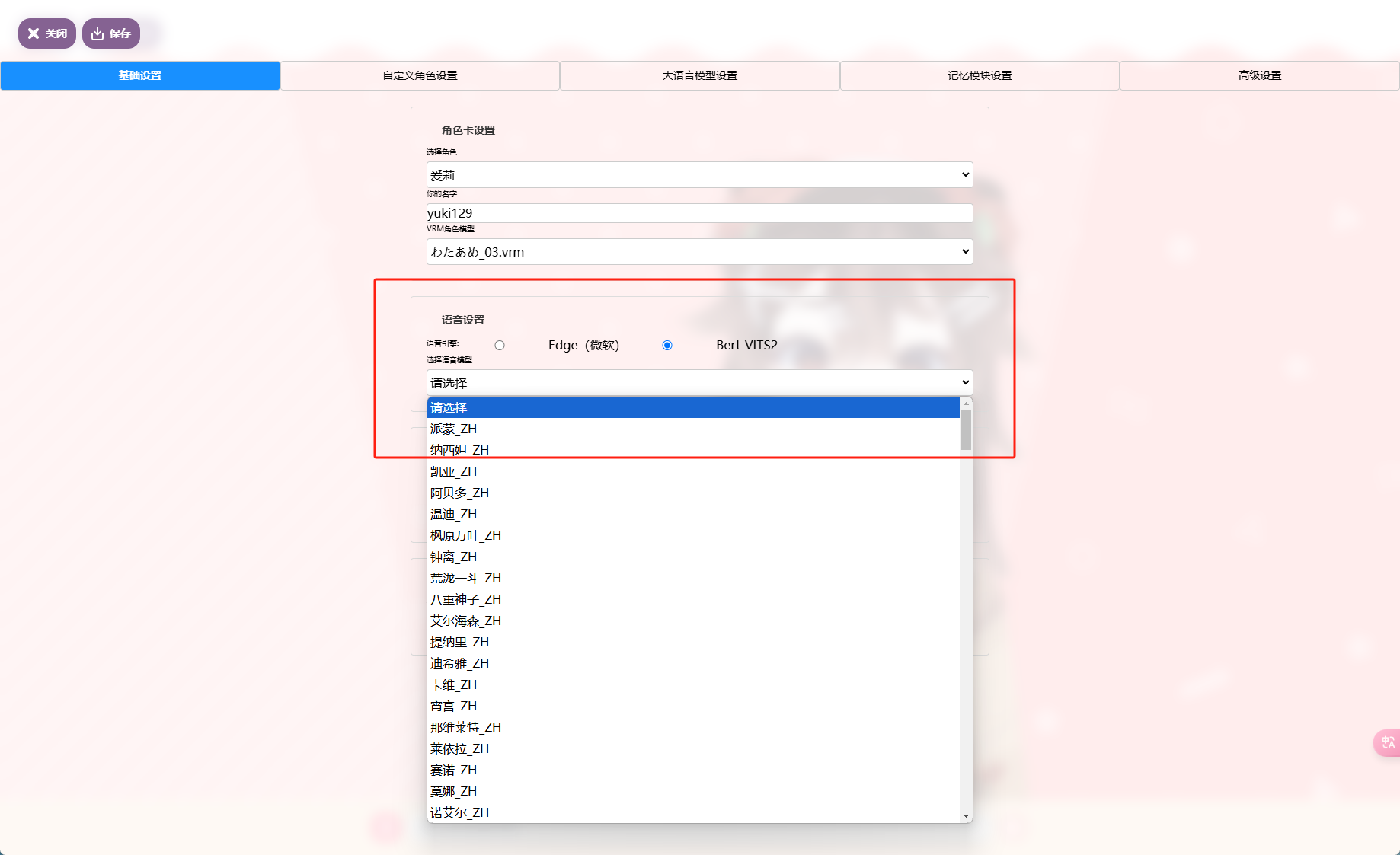

主界面在使用项目之前,我们还需要设置好AI相关事宜,同时在设置中你也能看到其他一些设置。首先是基础设置这里,能看到角色卡的设置,这里包含了角色选择、你的名字以及角色模型选择。下方则可以设置人物的语音,项目提供了微软和Bert两个引擎,里面有很多模型选择,最后则是AI的选择和壁纸设置了。

基础设置

基础设置切到自定义角色这里,这里可以创建新角色,例如设置角色的名称、基本信息、描述以及背景之类的,下方提供了其他模型的上传界面,在前文中提到的网址下载模型上传就可以了。

自定义角色

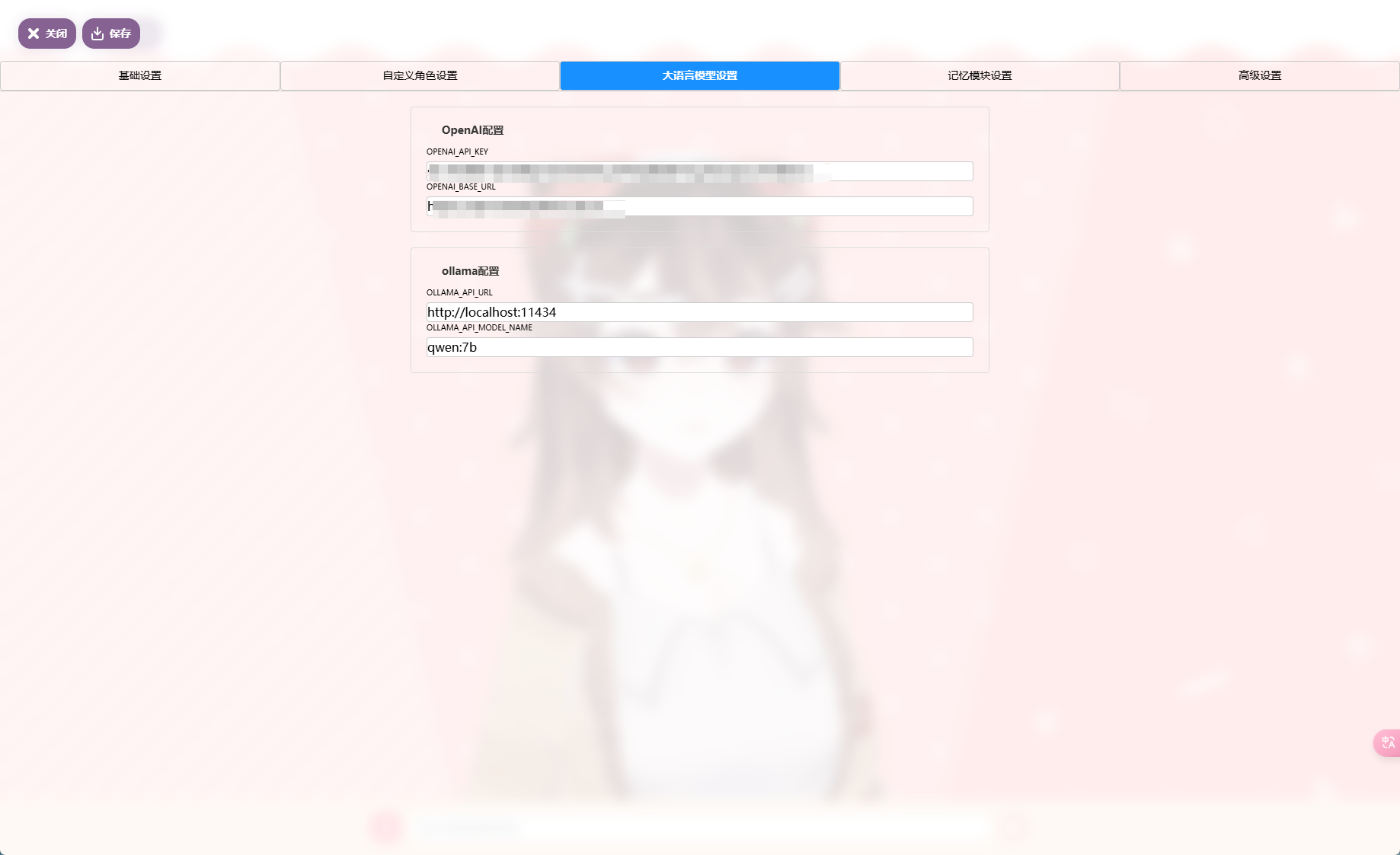

自定义角色大模型设置这里,提供了OpenAI以及ollama两个模型的配置,按照要求填写就可以。

模型设置

模型设置最后还有个长期记忆设置,也就是对话记忆,开启需要设置对应的存储池,采用db数据库,如果有的话可以设置上,这样AI能记住你的所有历史沟通问题,慢慢的变成你的形状。

记忆设置

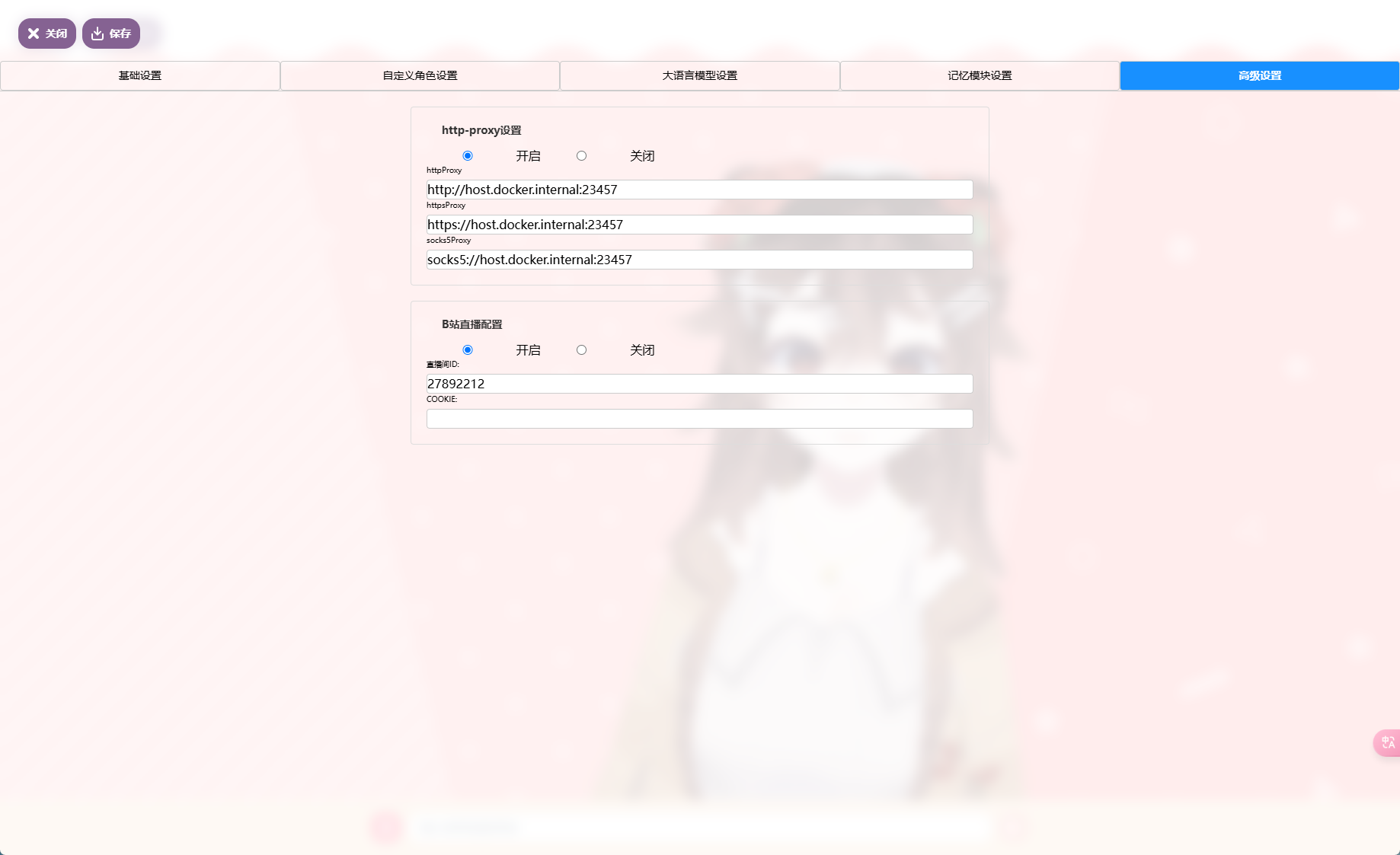

记忆设置最后高级设置提供了proxy代理以及B站直播解读弹幕的功能,打开该功能的情况下,你的赛博女友会直接读取弹幕内容并回复,也就是咱们常说的Vtuber,不过熊猫并没有实验过,感兴趣的可以尝试一下。

高级设置

高级设置总结

项目运行过程性能占用还是比较高的,主要在于模型的语音和动作,AI因为用的是在线模型所以不涉及本地计算,这算是降低了本地的一些工作量,不过还是推荐8G以上内存,像是熊猫这里用到的DXP4800也是后期加了内存条补到了16G。

以上便是本期的全部内容了,如果你觉得还算有趣或者对你有所帮助,不妨点赞收藏,最后也希望能得到你的关注,咱们下期见! 三连

三连